Чек-лист. Что проверять на сайте каждый день, чтобы внезапно не потерять трафик

- 3 мин.

- 10.03.2019

Чтобы трафик на сайте внезапно упал, достаточно случайно удалить одну страницу или не заметить баг. Причем трафик снизится не сразу, а через неделю-другую. Потом понадобится еще неделя на поиск ошибки и еще месяц на то, чтобы трафик восстановился.

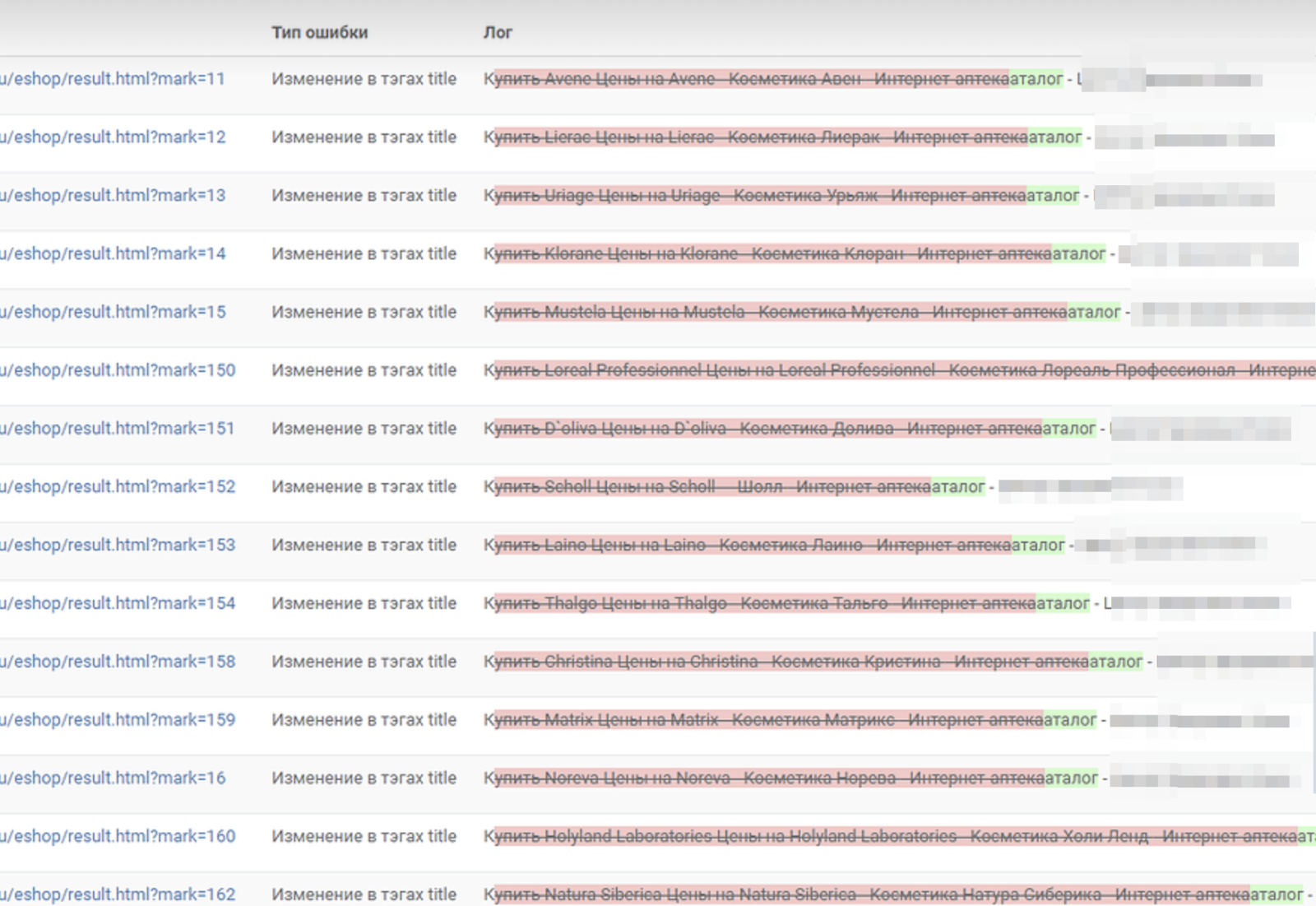

К примеру, на этом сайте слетели заголовки <title>, красным старые значения, зеленым — новые:

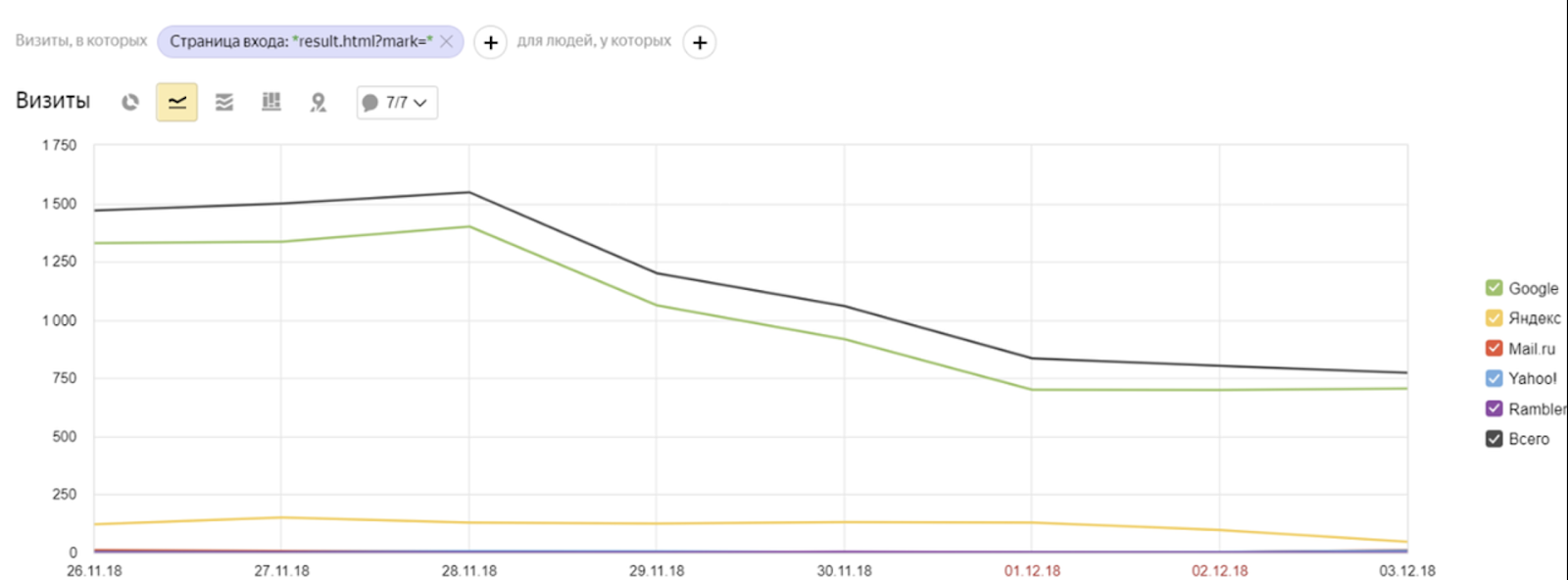

Программисты не увидели ошибку, и на следующей неделе трафик снизился:

Рассказываем, как ловить такие ошибки на следующий день и не жертвовать трафиком.

Как действовать

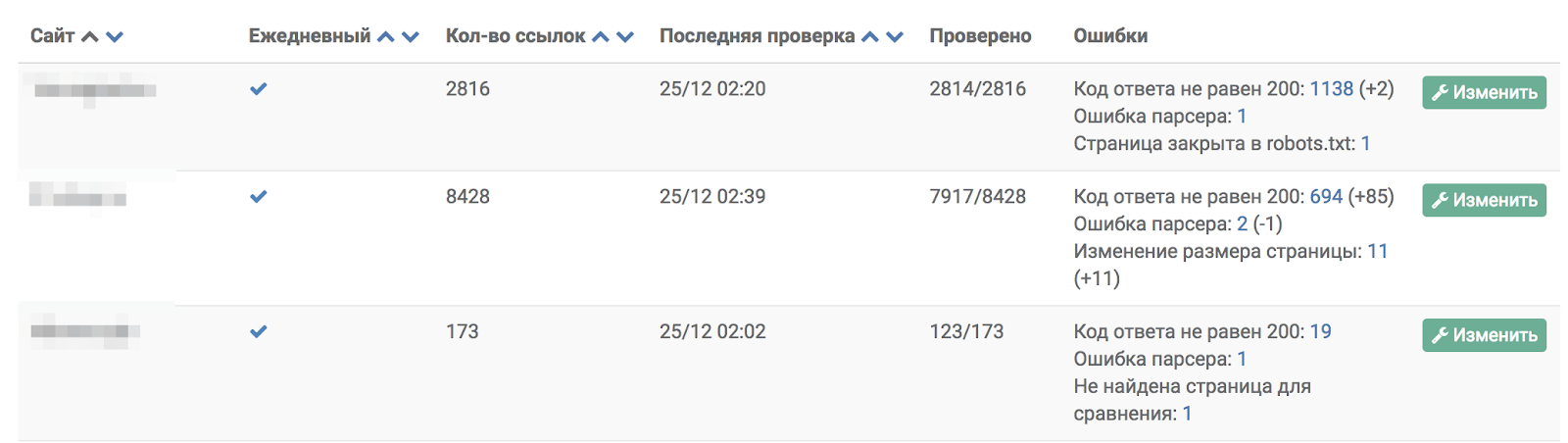

Мы ежедневно мониторим все продвигаемые страницы сайтов с помощью собственного скрипта. Он сравнивает страницы с их версией накануне и отправляет сводную информацию оптимизатору.

Оптимизатор просматривает изменения. Если они могут привести к потере трафика, он связывается с программистом и тут же устраняет проблемы. Так мы успеваем поймать ошибки до того, как трафик начал падать.

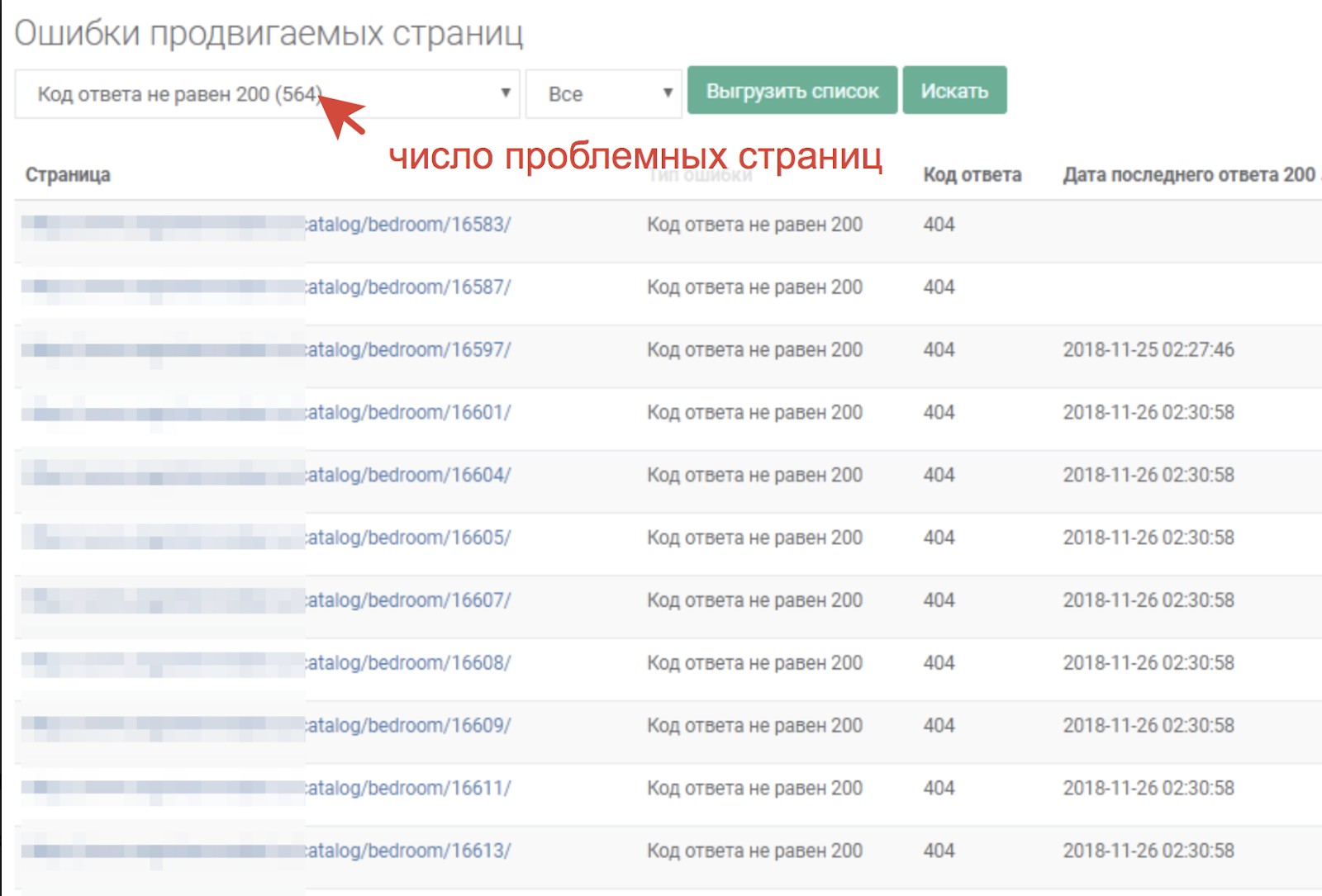

К примеру, здесь клиент удалил с сайта пятьсот товаров. Из-за этого частично пропал контент на разных страницах:

На следующий день наш мониторинг показал проблему:

Для проверки мы используем свой софт. Но недавно подобная функция появилась в Яндекс.Вебмастере — правда, она делает ограниченное число проверок. Поэтому скрипт можно разработать индивидуально для себя.

Что проверять

Каждый день скрипт проверяет изменение таких параметров:

- robots.txt. Одна неправильная строчка в файле, и весь сайт будет закрыт для индексации поисковыми системами;

- sitemap.xml. Карта сайта — второстепенный функционал, но она должна работать;

- <'title'>. Это самый важный заголовок, по которому поисковик понимает, какой теме посвящена страница. Она выводится в сниппете;

- тегов заголовков от <'H1'> до <'H6'>. Они помогают поисковику распознавать структуру контента;

- тега <'noindex'>. Неправильное использование этого тега может закрыть от поисковика часть важного контента страницы;

- meta-robots. Неправильная директива в этом мета-теге запрещает поисковику добавлять страницу в индекс;

- в других тегах и метатегах;

- размера страницы. Оптимизатор обращает внимание, если страница глобально изменилась;

- код ответа страницы. Если в нашем скрипте ответ отличается от 200 ОК, это повод для проверки.

Такой список параметров появился не сразу. Мы добавляли в мониторинг те параметры, которые хоть раз наносили урон трафику в проектах наших клиентов.

А такой парсинг не опасен?

Когда говорим клиентам, что будем каждый день парсить по десять-двадцать страниц, мы обычно видим недовольство программистов. Они боятся, что сайт упадет из-за чрезмерной нагрузки.

Это обоснованные страхи, поэтому мы предусмотрели вопрос нагрузки:

- меняем количество потоков и интервал между запросами, если сайт не выдерживает 5—10 потоков одновременно;

- проверяем изменения ночью, когда нагрузка низкая. Обычно мониторинг проходит в два часа ночи;

- при угрозе чрезмерной нагрузки сокращаем количество страниц до списка критичных.

Наш робот использует user-agent DSSpider, поэтому по логам сервера легко отделить наши запросы от чужих.

Будет полезно

- Гиперлокальный таргетинг: что такое, как работает и для чего нужен

- Способы уменьшения высокой стоимости заявки (CPL) в рекламе

- Семь базовых показателей эффективности контекстной рекламы или как читать отчеты специалистов

- Необходимый минимум о маркировке рекламы в 2023 году: что база, а что — нюансы. Где начинается административная ответственность, и какова цена ошибки

Блог

Блог