Как без навыков SEO оптимизировать новый сайт до запуска, чтобы получить как можно больше органического трафика

- 25 мин.

- 8.01.2020

С воодушевлением сделали дизайн, написали тексты, заверстали сайт и… вдруг вспомнили, что забыли о SEO. Что же делать!?

Спокойно, всё поправимо! Рассказываем, как быстро оптимизировать сайт без навыков в SEO.

Проверить настройки сервера

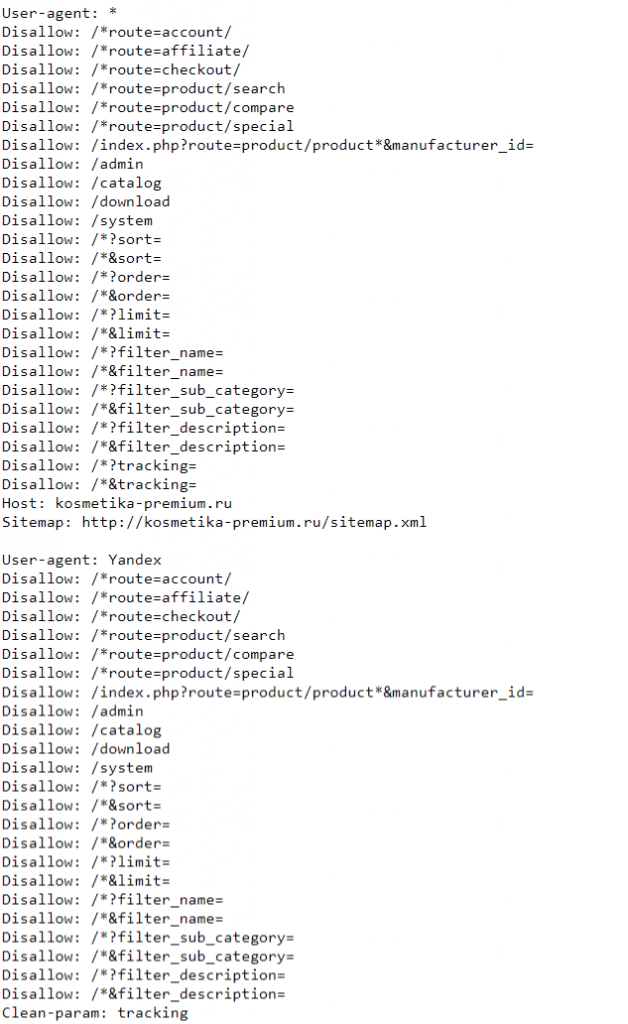

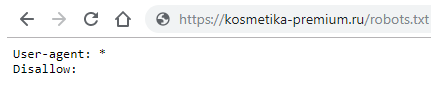

Зайдите в домен, на котором вы планируете выкладывать сайт, и откройте файл robots.txt.

Проверьте, что в robots.txt нет запрещающей директивы “Disallow: /”. Иначе сайт не будет индексироваться.

Обычным поиском в документе robots.txt напишите Disallow: / и убедитесь, что там такой фразы нет:

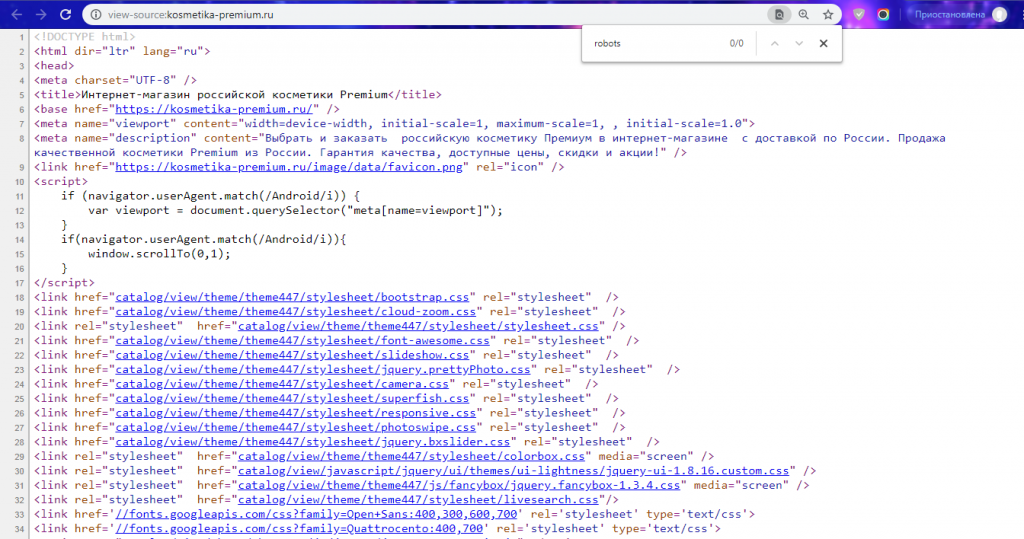

В метатегах главной страницы нет метатега robots со значениями noindex или nofollow. Нажмите правой кнопкой мыши по главной странице сайта и зайдите в «Просмотреть код» (или CTRL+U, если работаете в Windows).

В поиске введите строку <meta name=»robots» content=»noindex» /> — ее не должно быть, иначе страница будет запрещена к индексации.

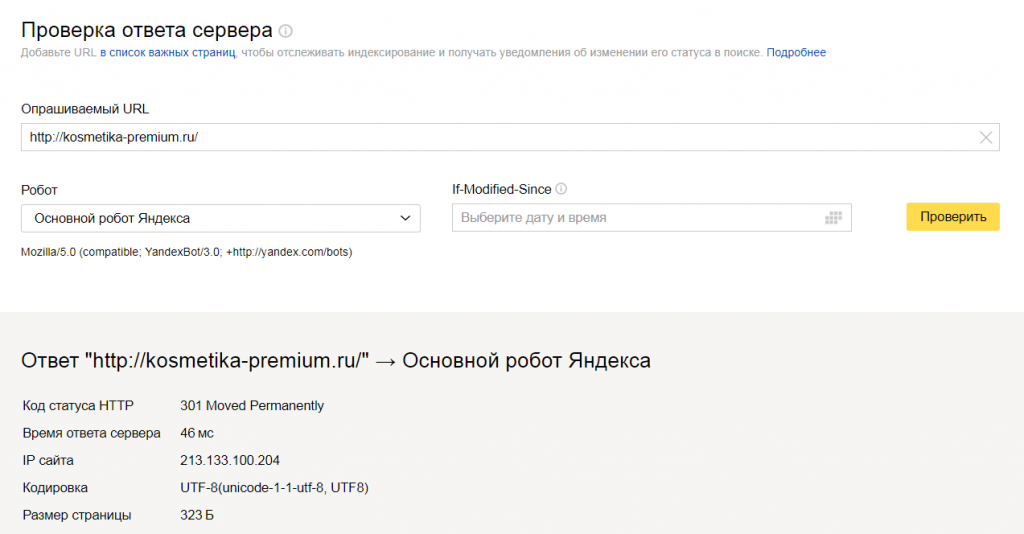

Настроены редиректы. Редирект — перенаправление пользователя с одной страницы на другую:

- с http-версии на https-версию. То же самое для других вариантов написания адреса сайта — с или без WWW;

- с HTTP — 301-й редирект на HTTPS.

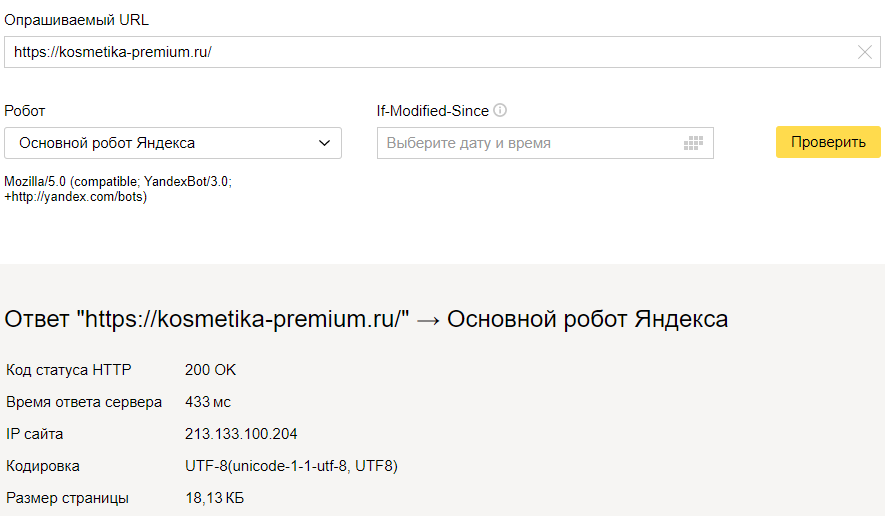

Чтобы проверить, зайдите в панель вебмастера, введите адрес страницы, которую хотите проверить, и найдите строку: «Код статуса HTTP». Должно быть так:

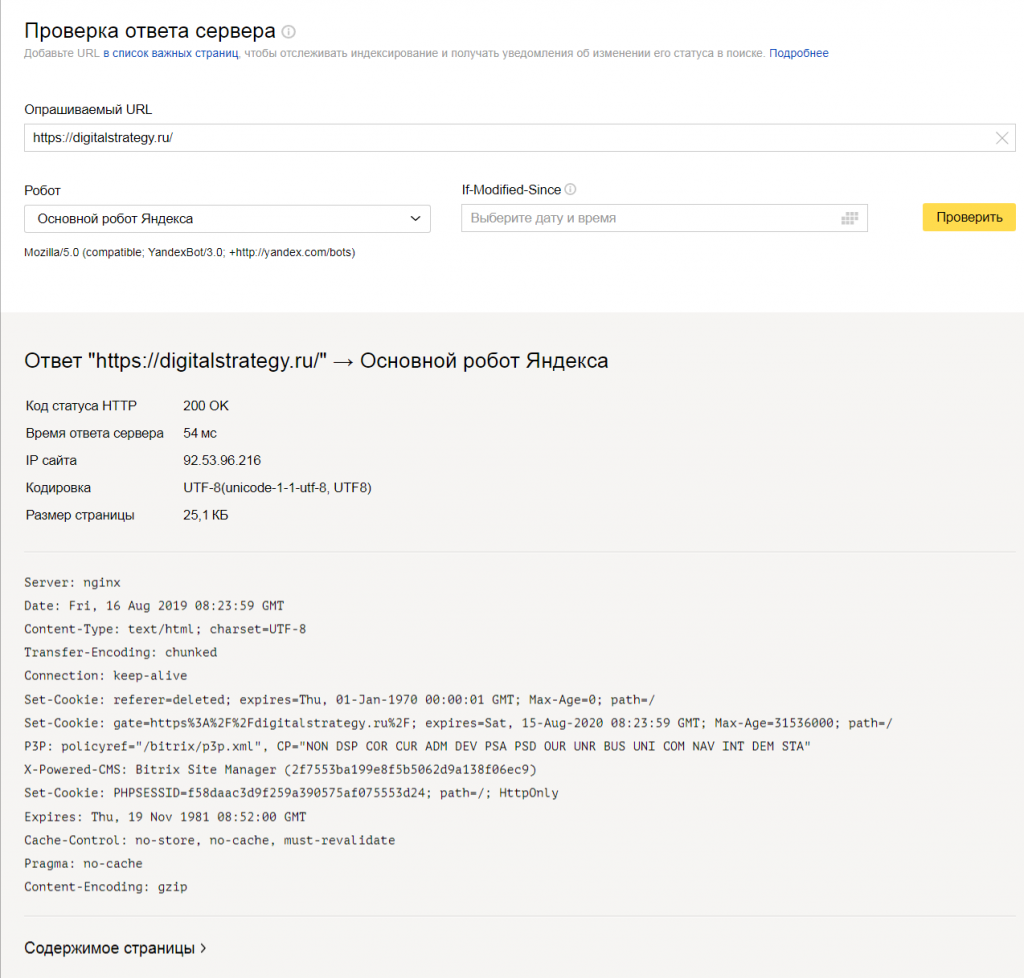

Заголовки, описания, контакты считываются поисковиками. В Яндекс.Вебмастере и Google Search Console посмотрите страницы как их видит робот.

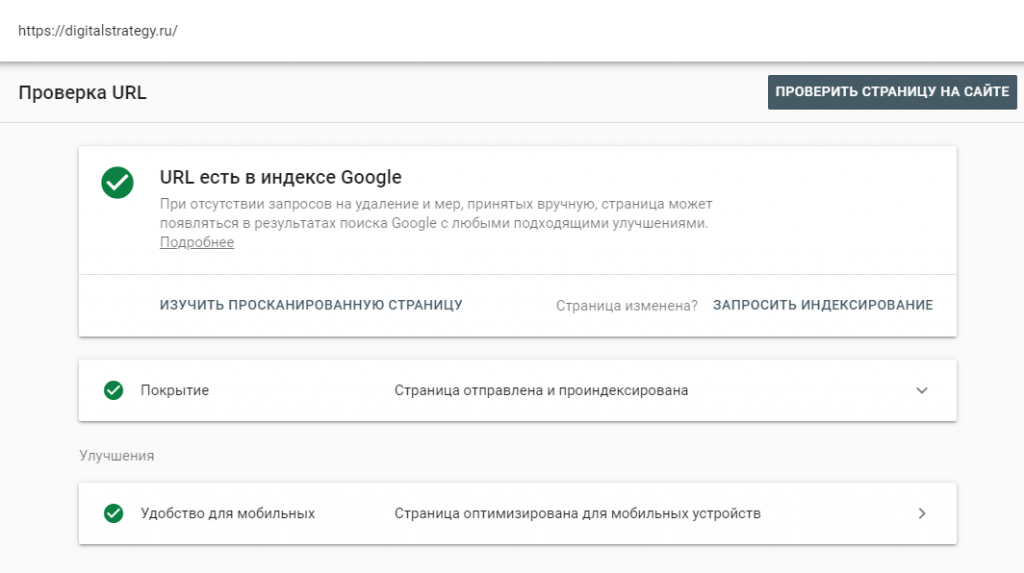

В Яндекс.Вебмастере нажмите «Содержимое страницы», в Google Search Console — «Изучить просканированную страницу».

В Google Search Console нажмите «Изучить просканированную страницу»

Вы увидите код, как видит его поисковик. Проверьте, есть ли в нем все заголовки и текст, которые должны быть на ваших страницах. Бывает, что текста в коде нет, и тогда поисковики его не индексируют.

Поставить информативную заглушку

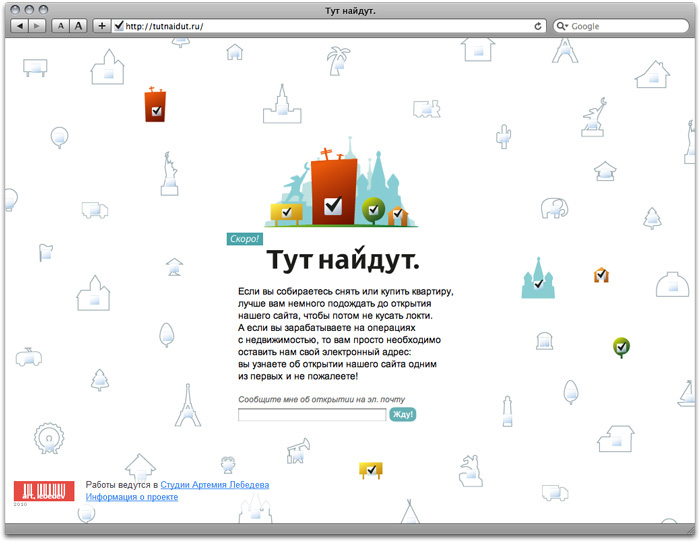

На домене должен лежать сайт. Но пока его нет, разместите заглушку. Хорошая заглушка рассказывает посетителю, куда он попал и когда откроется сайт.

По удачной заглушке понятно, что это за компания и чем занимается. На ней кратко описаны товары и услуги, есть форма сбора емейлов, чтобы потом напомнить потенциальным покупателям, что сайт открылся. Вот неплохой пример:

Благодаря тексту на заглушке сайт будет оставаться в выдаче поисковиков и начнет копить возрастные метрики. То есть когда опубликуете сайт, у него уже будет определенный вес у поисковиков.

Старайтесь избегать абстрактных фраз, вроде «Сайт находится в разработке» или «Зайдите позже»:

Настроить Яндекс.Вебмастер

Яндекс.Вебмастер показывает, что поисковик знает о сайте.

Сайт добавлен в Яндекс.Вебмастер. Тут всё просто: заходите в Вебмастер, и там есть ваш сайт.

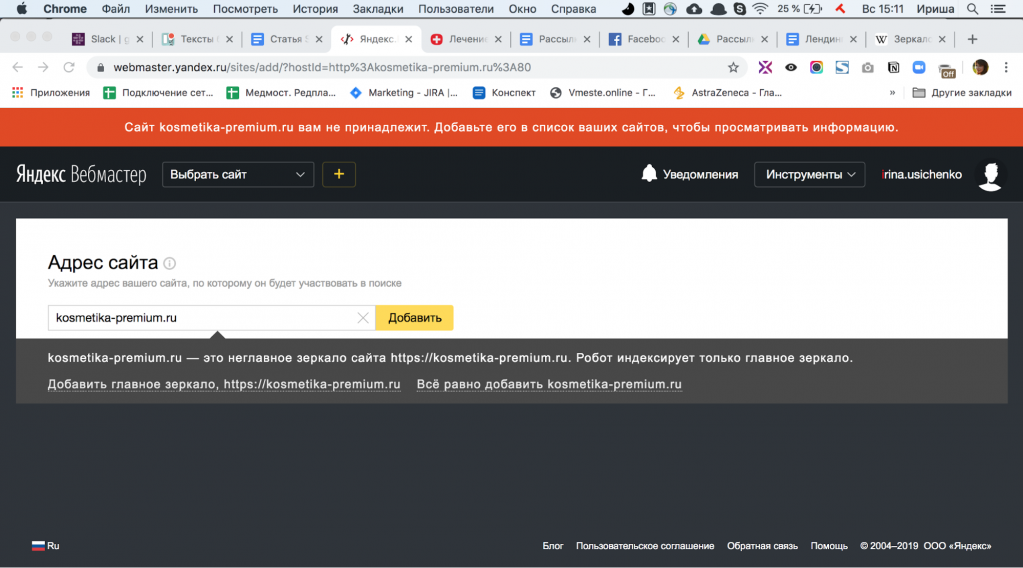

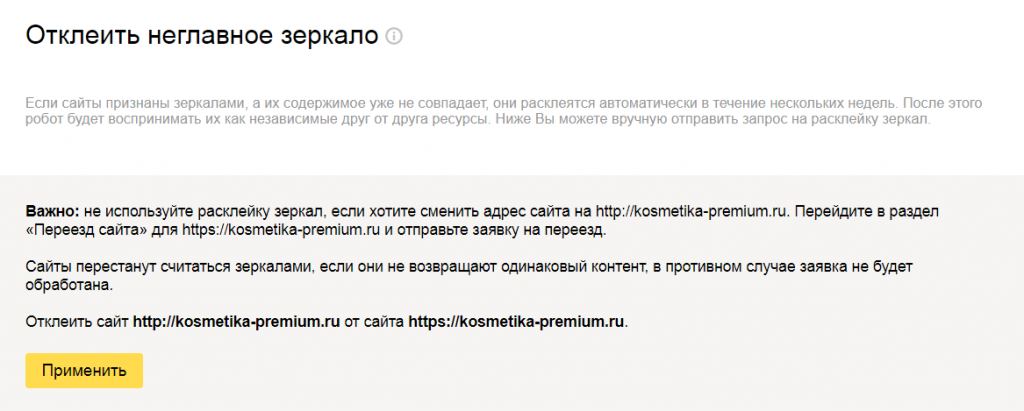

Https-версия сайта — главное зеркало, и никакие другие домены не приклеены к сайту. Зеркало сайта — это его точная копия, но с другим адресом. Например, http://kosmetika-premium.ru и https://kosmetika-premium.ru с одинаковым контентом будут зеркалами. Сайт с https в адресе должен стать главным зеркалом.

К примеру, у нас есть сайт kosmetika-premium.ru:

- — Перейдите в Вебмастер в раздел «Зеркала» и введите адрес сайта. Вебмастер покажет, какой адрес — главное зеркало.

- — Если это не сайт с https, нажмите «Добавить главное зеркало».

Сайты не считаются зеркалами, если они не возвращают одинаковый контент, — тогда заявка не будет обработана.

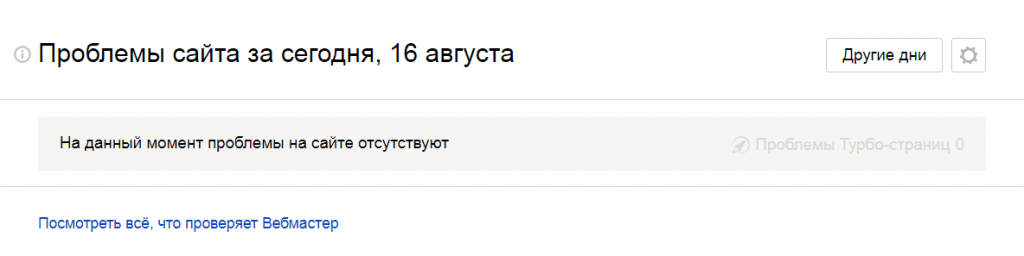

В разделе «Диагностика сайта» нет фатальных и критичных ошибок. Вам главное увидеть надпись «На данный момент проблемы на сайте отсутствуют»:

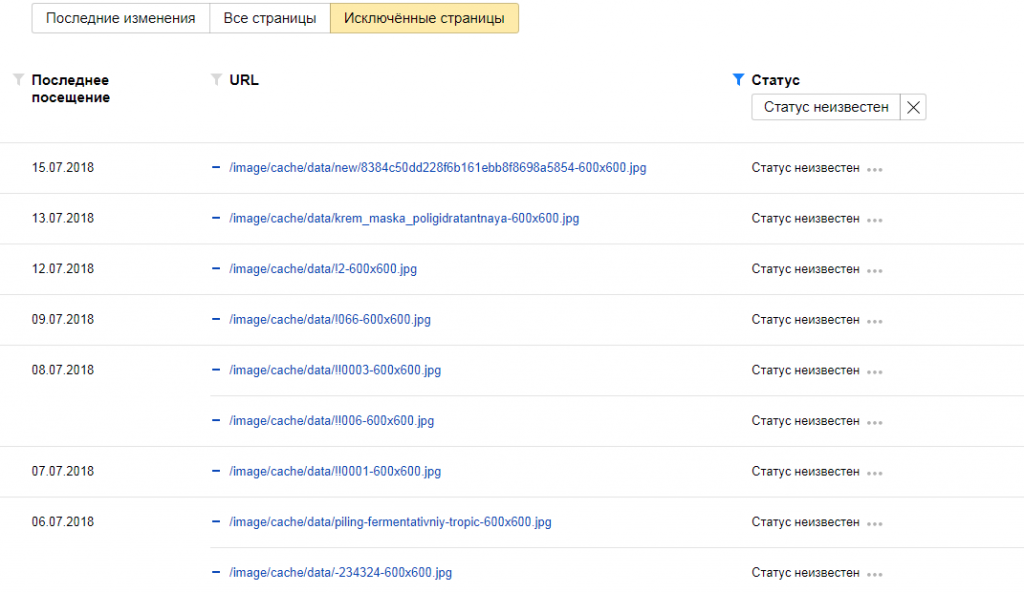

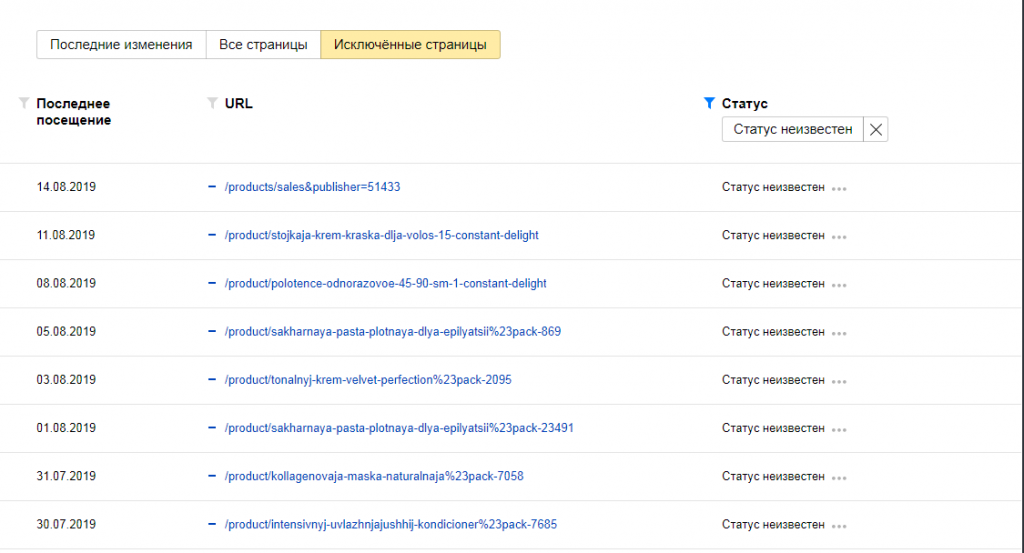

В разделе «Страницы в поиске» выводятся проиндексированными страницы и заглушки. Другие страницы не индексируются, в «исключенных страницах» пусто.

Вот здесь несколько изображений попали в исключенные страницы, они не индексируются. Нужно передать информацию разработчику и проверить, что происходит с сайтом:

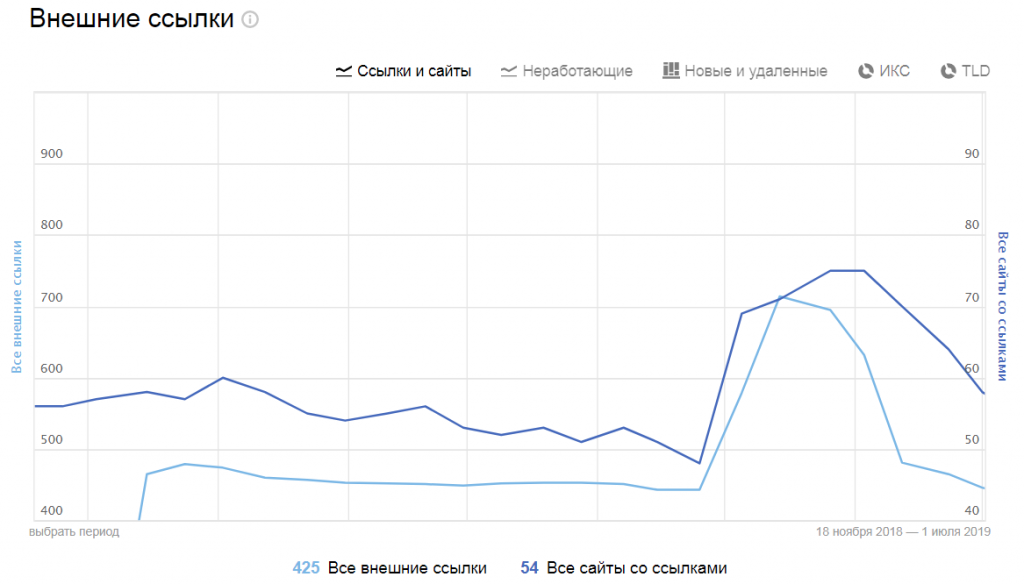

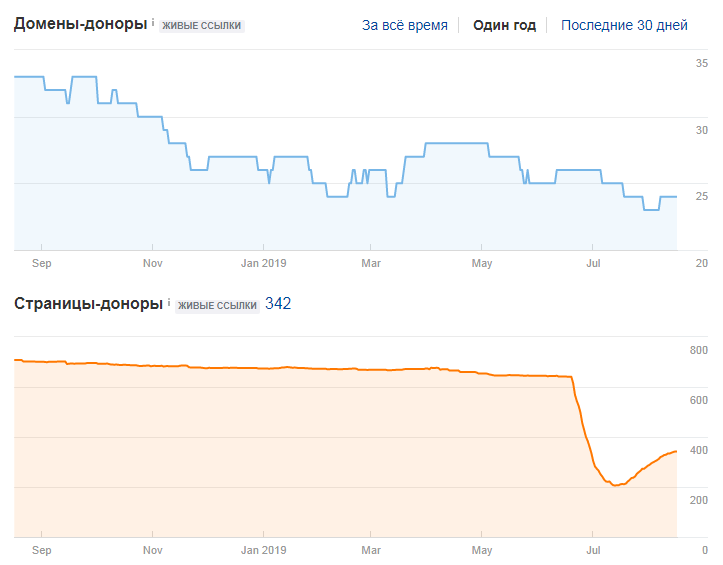

Во «Внешних ссылках» нет резких скачков. На графике видно, что в январе 2019 года возник провал: большая часть сайтов перестала ссылаться на наш сайт:

Если видите такую картину, нужно выяснить причину. Например, сайты с ссылками на ваш сайт могли закрыться:

Настроить Google Search Console

Теперь идем в консоль Гугла.

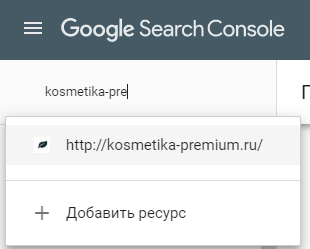

Сайт добавлен в Search Console. Заходите в консоль и проверяете, что там есть ваш сайт:

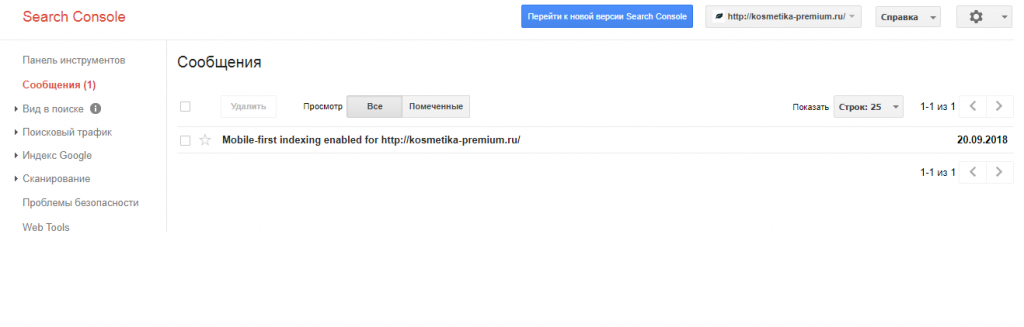

В разделе «Сообщения» нет информации об ошибках. Если есть письма об ошибках, передайте их разработчику:

В разделе «Поисковый индекс» — только страницы, которые относятся к заглушке.

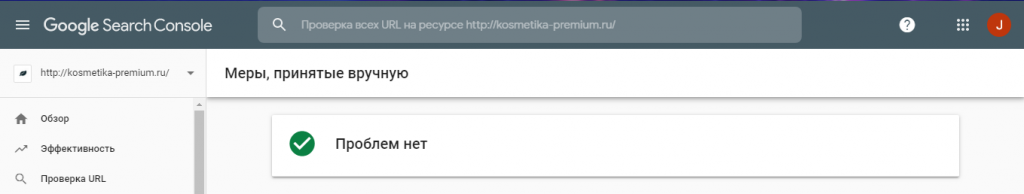

В разделе «Меры, принятые вручную» нет предупреждений. Например, о том, что вы рассылаете агрессивный спам. Вот здесь все хорошо:

Проверить домен

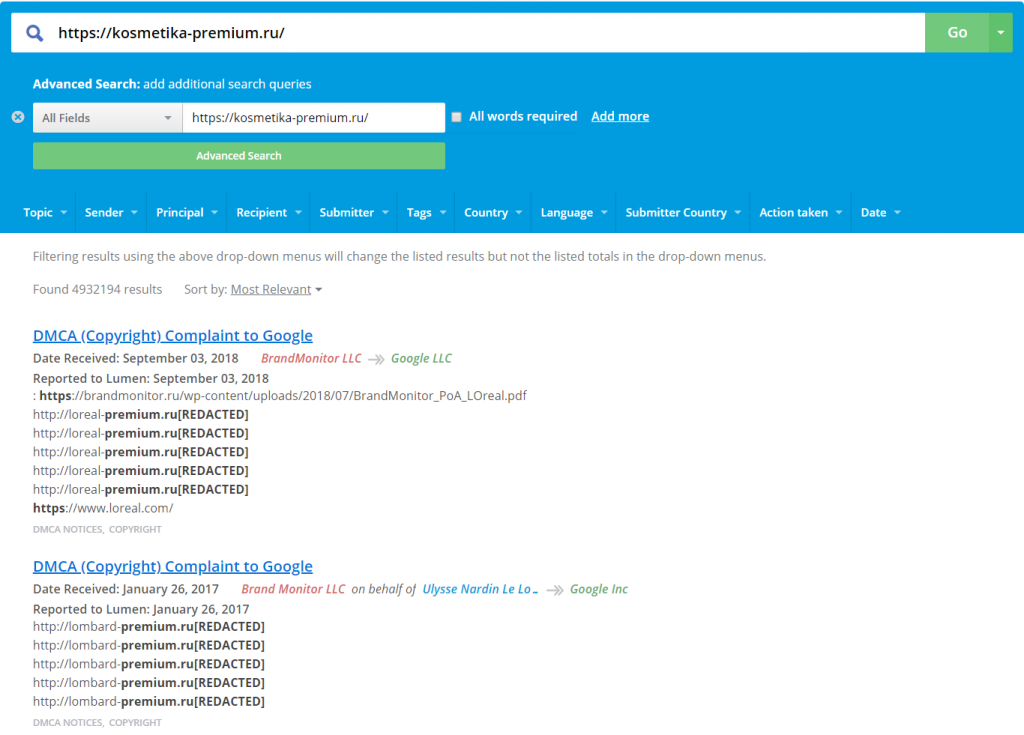

Зайдите в Lumen — базу правообладателей, там копятся иски и жалобы. Если какой-то бренд находит в сети незаконное размещение своих материалов, он пишет жалобу

Проверьте, нет ли на домене страниц ваше сайта, которые удалены по DMCA. Введите адрес своего сайта в поисковую строку:

В результатах поиска — нет нашего сайта. Это значит, не будет вопросов по правам на контент:

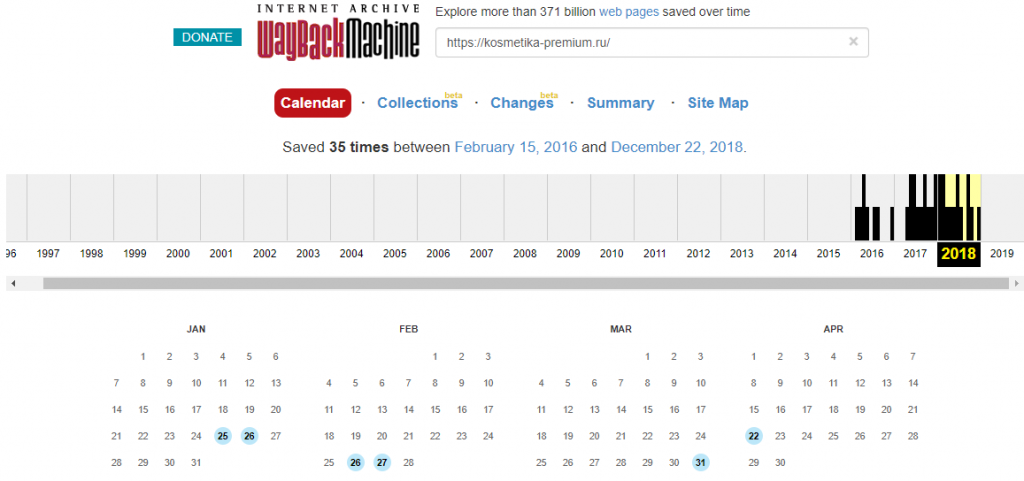

Посмотреть историю домена

В Вебархиве проверьте историю по домену, на котором планируете размещать сайт. Выберите в календаре прошлые даты и посмотрите, какой контент был на страницах. Главное, чтобы в прошлом по этому адресу не было казино, взрослого или другого запрещенного контента.

Если кликнуть на выделенные даты в календаре, увидите, как тогда выглядела страница сайта и что на ней было размещено

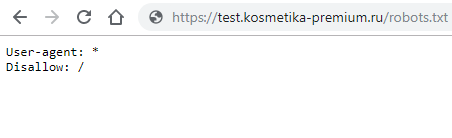

Проверить, что тестовые сервера закрыты от поисковиков

В robots.txt должны быть прописаны такие настройки:

Просто скопируйте их и вставьте в свой файл:

User-agent: *

Disalow: /

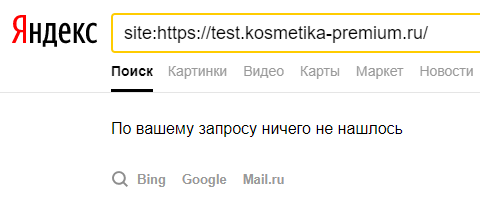

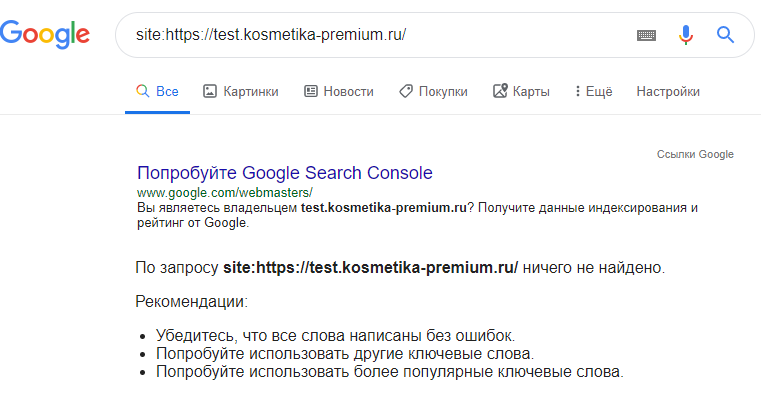

В индексе поисковиков нет контента страниц сайта с других серверов

Впишите в поисковой строке такую фразу: «site: адрес сайта»

В Яндексе:

В Google:

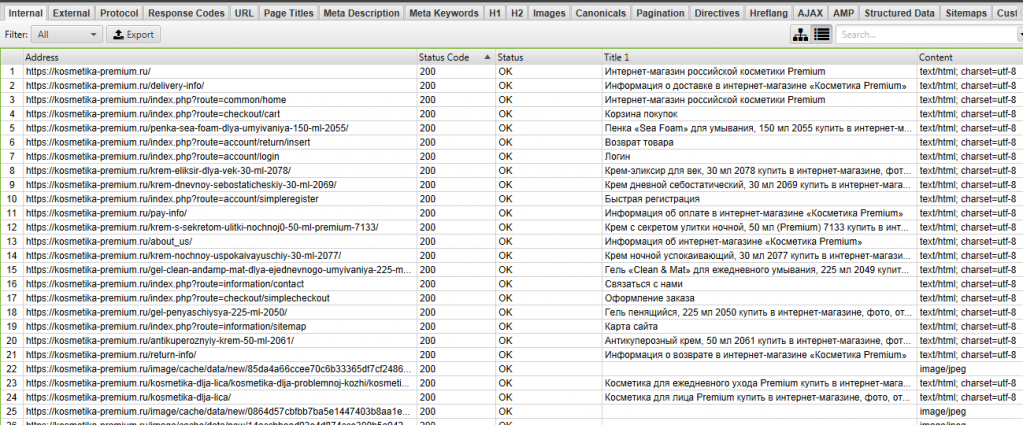

Собрать сайт эмулятором поисковиков

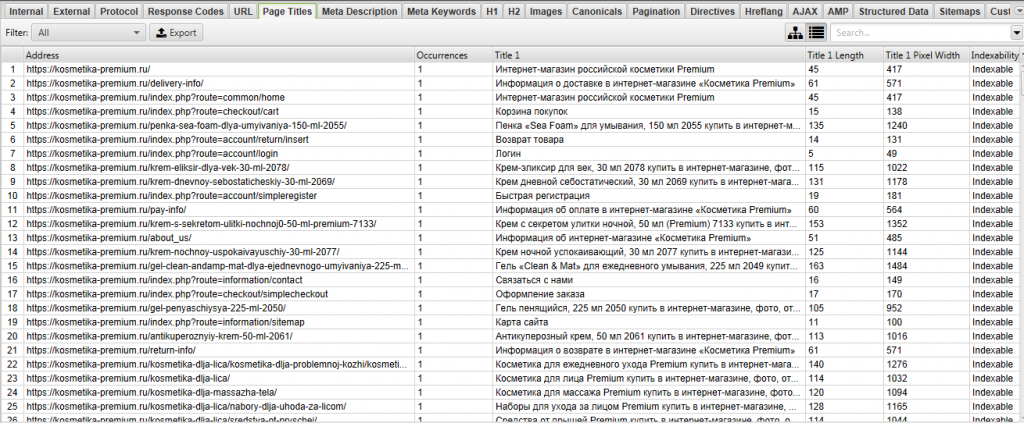

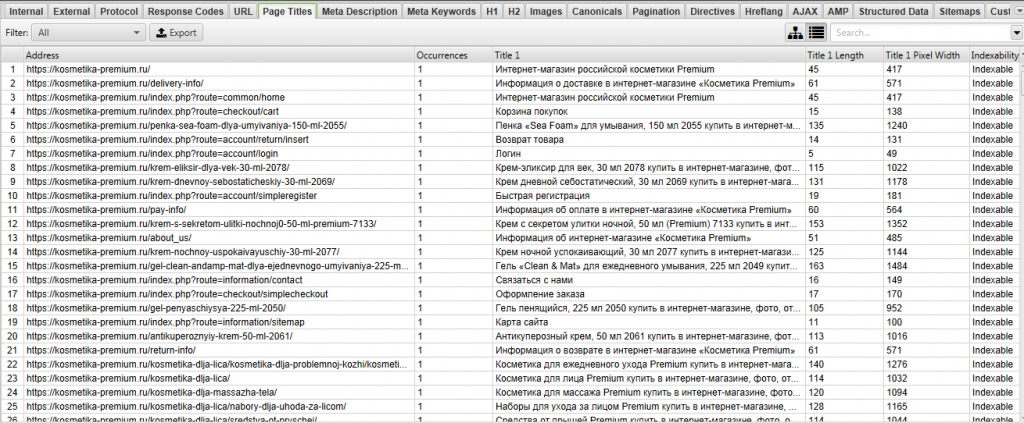

| Эмулятор поисковиков — это программа, которая имитирует поискового робота. Мы используем Screamingfrog. Что проверить: |

- находит все нужные страницы. Вы видите в списке все страницы, которые должны видеть поисковые системы.

- нет бесконечных циклов сбора;

- все страницы отдают код 200 и нет 4хх (битых ссылок) или 3хх (редиректов).

В графе Status Code не должно быть ошибок с трехзначным кодом, которые начинаются на 4 или 3:

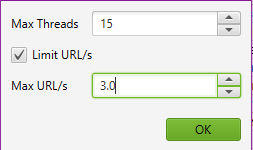

Сайт не падает от парсинга в несколько потоков. Пропарсите сайт с помощью screamingfrog с двумя параметрами: количество потоков и количество URL в секунду. До десяти потоков и до двух URL сайт должен работать:

Нет дублей страниц. Смотрим, чтобы не было страниц с одинаковыми адресами и содержанием:

Title и metadescription соответствует содержимому страниц. В Title должно быть то, что на самой странице:

После выкладки сайта

Теперь сайт можно выкладывать, но после запуска нужна дополнительная проверка.

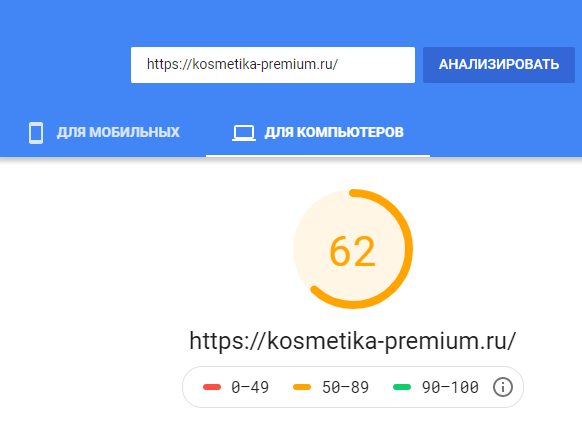

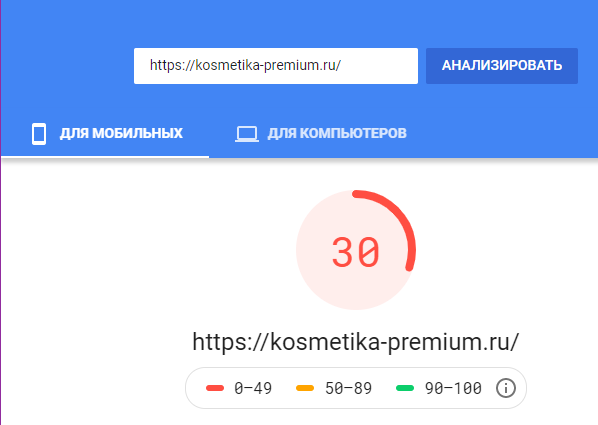

Скорость рендеринга основных типовых страниц в Google PageSpeed. Нужно проверить десктопную и мобильную версии. График должен быть в зеленой зоне или хотя бы в зоне 70-89%:

Такую картину нужно показать разработчику, чтобы он исправил ошибки и вывел мобильную версию в зеленую зону.

Сейчас на сайте могут быть неоптимизированные изображения или другие ошибки:

Время ответа сервера в Яндекс.Вебмастере. Оптимально — не более 500 мс.

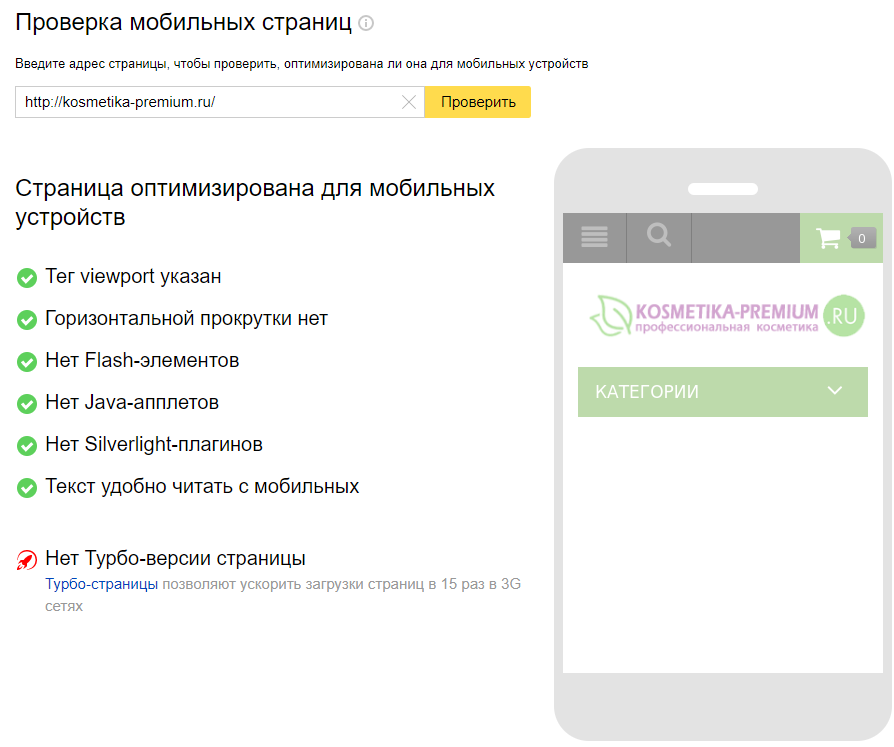

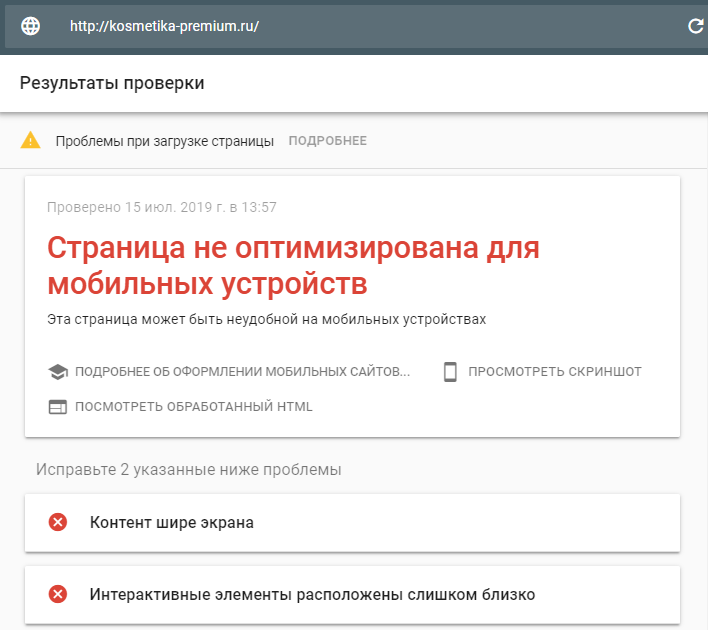

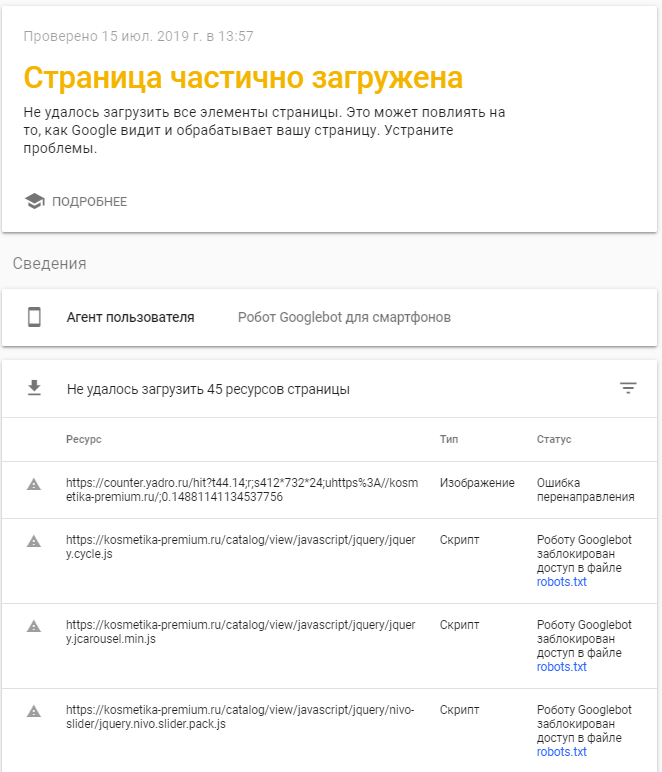

Адаптивность типовых страниц в Google Mobile Friendly и Яндекс.Вебмастере. В идеале в Яндексе вы должны увидеть такую картину:

Если вы получите сообщение, что страница не адаптирована для мобильных устройств или частично загружена, бейте тревогу и обращайтесь к разработчику.

Такая картина — повод обратиться к разработчику:

Коды ответа при обращении к несуществующим страницам в Яндекс.Вебмастере. Добавьте к адресам страниц / или что-то допишите. К примеру:

Оригинальный URL:

- https://kosmetika-premium.ru/kosmetika-dlja-massazha-tela/ — 200 OK

Модифицированный URL:

- https://kosmetika-premium.ru/kosmetika-dlja-massazha-tela/ — 404 Not Found

- https://kosmetika-premium.ru/kosmetika-dlja-massazha-tela/ — 301 Moved Permanently

- https://kosmetika-premium.ru/kosmetika-dlja-massazha-tela/ — 301 Moved Permanently

По страницам с неправильными адресами должны получать статус 301 Moved Permanently или 404 Not Found.

С тестового сайта не перенеслись настройки закрытия от поисковиков. Нет метатега robots=noindex и директивы disallow в robots.txt:

В первые недели после выкладки

Индексация в Вебмастере. Зайдите в Вебмастер и проверьте, чтобы в выдаче были только страницы сайта и не было мусорных страниц. Мусор — это страницы сортировок, фильтраций, utm-меток.

Правильные логи вебсервера. Их запрашивают у разработчика. Логи показывают, какие страницы посещают поисковые роботы — страницы сайта или мусорные. В записях посещения сайты должны быть строки с именами Яндекса и Гугла, это и есть роботы.

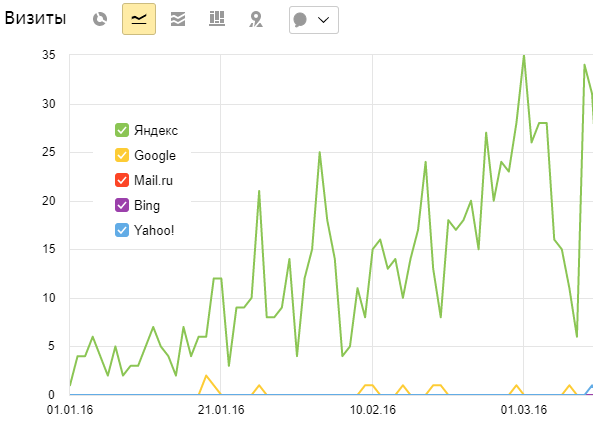

Переходы в Метрике и Analytics должны расти:

На этом пока всё!

Будет полезно

- Чек-лист. Что проверять на сайте каждый день, чтобы внезапно не потерять трафик

- Семь базовых показателей эффективности контекстной рекламы или как читать отчеты специалистов

- Продвижение интернет-магазина парфюмерии и косметики

- Продвижение сайта медицинских услуг: в три раза увеличили органический трафик на сайт

Блог

Блог